timeout参数的使用

在某些网络情况不好或者服务器端异常的情况会出现请求慢或者请求异常的情况,这个时候我们需要给

请求设置一个超时时间,而不是让程序一直在等待结果。写一个简单的例子:

import .requests

response = requests.get('https://www.linfengnet.com/', timeout=3)

print(response.text)

该例子必须在3秒内返回响应,否则会报错。你可以尝试输入一个错误的url,或者将timeout时间调小,比如0.1,则会出现timeout的报错。

reteying库

在上述例子中,我们讲述了超时报错。在我们的程序中,如果出现了报错,我们应该是进行异常捕获。

但是在实际操作中,如果你访问一个网站出现了报错,有可能是网络情况不好,这个时候我们应该是重新请求服务器,甚至是重新请求好几次。那我们在程序中可以做这个操作吗?

答案是肯定的,这就是重试,也就是接下来的要讲的retrying库,在使用之前需要自己pip install retrying。

写一个简单的例子:

import requests

from retrying import retry

#让被装饰的函数反复执行三次,三次全部报错才会报错,中间又一次正常都不报错

@retry(stop_max_attempt_number=3)

def parse_url(url):

response = requests.get(url, timeout=5)

return response.content.decode()

既然会报错,那我们就需要去捕获异常,接下来我们捕获异常,完善上述的例子。

import requests

from retrying import retry

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/64.0.3282.119 Safari/537.36'}

#让被装饰的函数反复执行三次,三次全部报错才会报错

@retry(stop_max_attempt_number=3)

def parse_url1(url):

print("*"*50)

response = requests.get(url, headers=headers, timeout=5)

return response.content.decode()

def parse_url(url):

try:

html_str = parse_url1(url)

except:

html_str = None

return html_str

if __name__ == '__main__':

print(parse_url('http://www.baidu.com'))

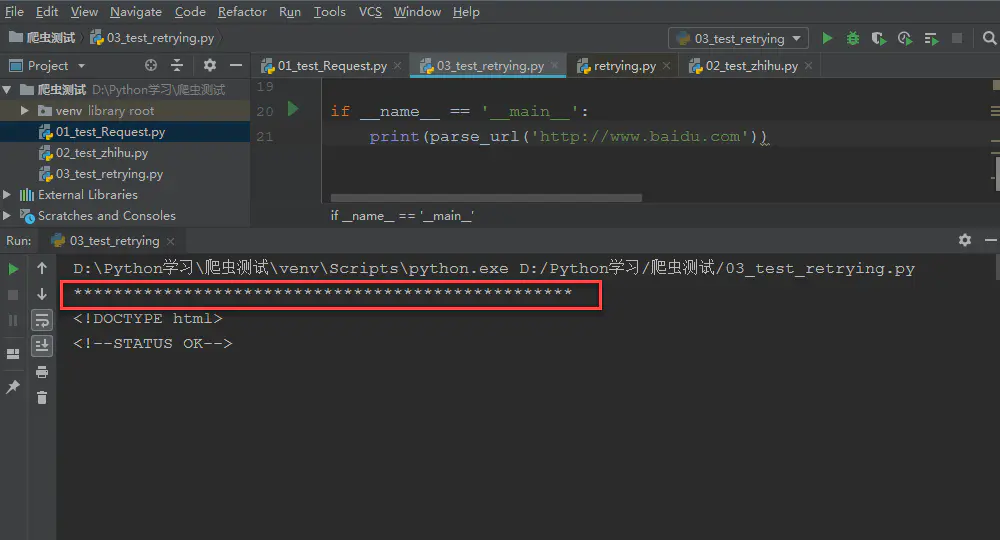

当我输入正确的url地址http://www.baidu.com时,程序只执行了一次,输出结果如下:

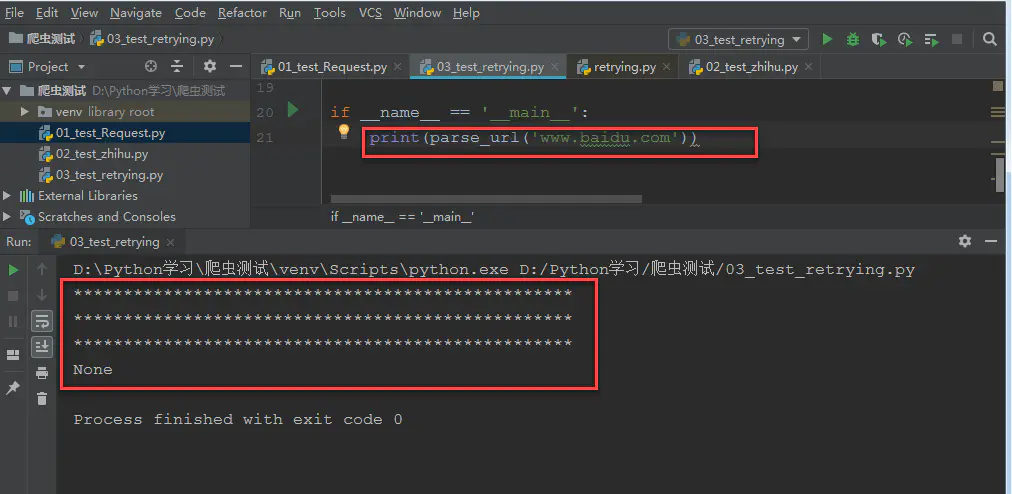

当我输入错误的url地址www.baidu.com时,程序retrying了3次,输入结果如下:

相关内容:

来源: